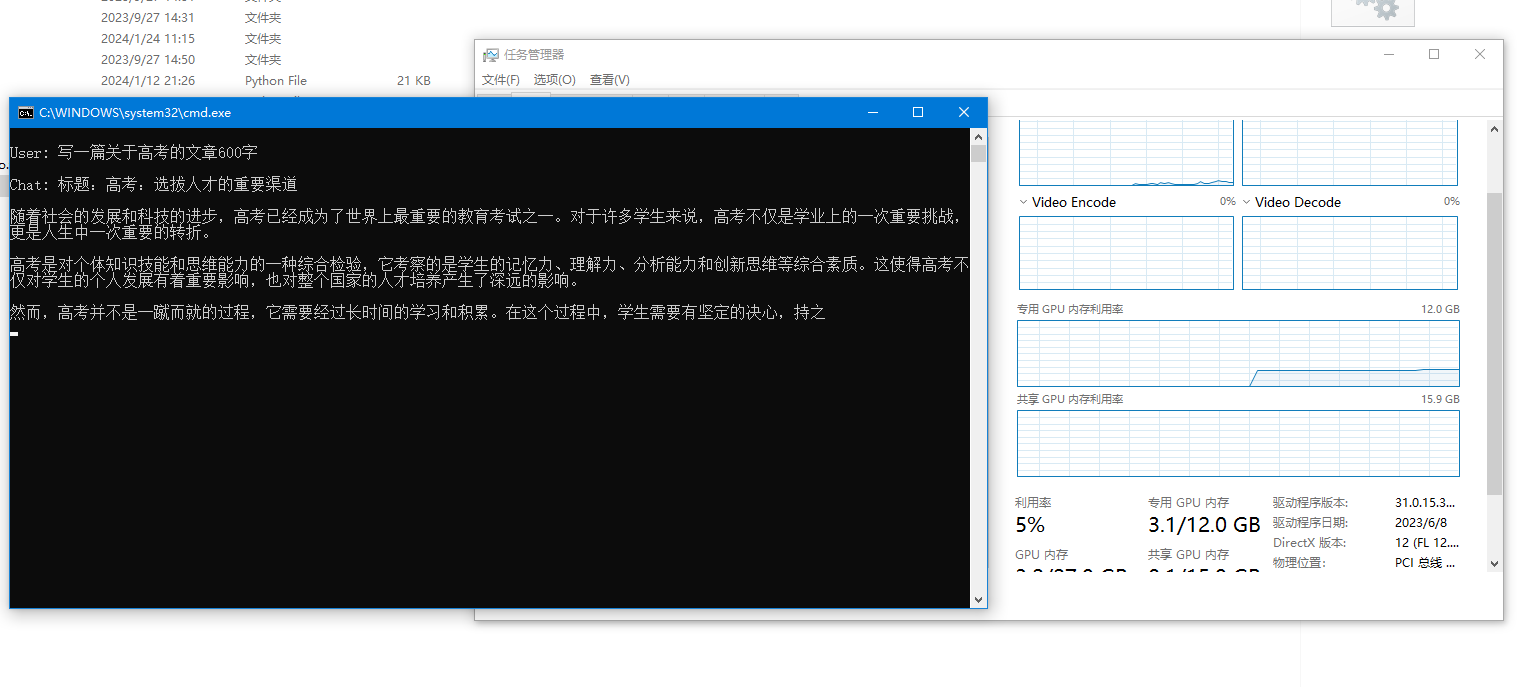

本来打算假期前更新出来的,因为一些事情拖到现在更新。今天带来的是阿里的千问通义本地大模型运行包,无需任何key,下载压缩点击即可运行。文件一共15G左右,需要准备最低20G以上的硬盘和最低显存4G。

硬件准备:

需要一张显存4G+的英伟达显卡。比如1070+,2060s+,3060+, 3090,+,4060+,4090等等

2. 软件环境

操作系统Win11/Win10

其他基本不需要自己准备。

3. 使用方法

首先,获取软件包并解压。最好是解压在某个盘的根路径下面。如果是子路径,注意不要用中文和空格。

特色:

无需任何其他环境配置,只需硬件跟上,解压即可使用,无需安装其他扩展。

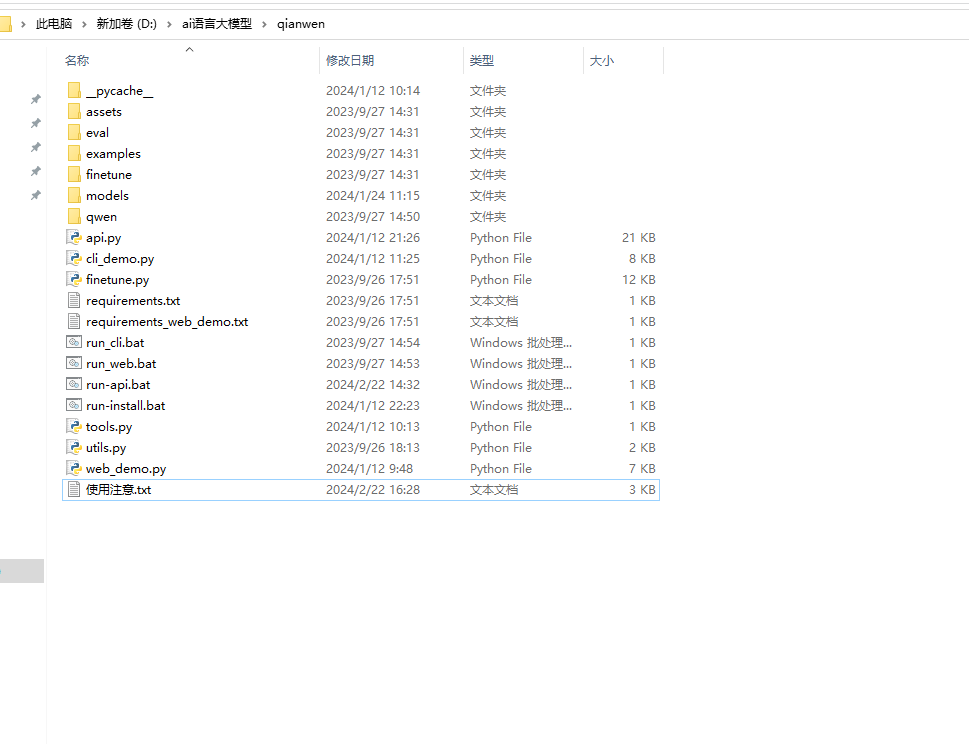

下载解压后的文件包为:

本模型为千问通义一键运行包,本模型默认使用的1.8B小模型,支持显卡显存最低3.5G即可。本一键安装包另外带7B模型,支持显卡为7G以上,如果你是高配显卡可以自己设置。

如果你想加入更高的千问模型,可以把模型包放入/models下 然后配置下即可。

本一键运行包,包括窗口运行,web运行,api运行三种方式

窗口运行文件为根目录的:cli_demo.py 如果要替换7B大模型,可以打开这个文件找到Qwen-1_8B-Chat-Int4,替换为Qwen-7B-Chat-Int4

web运行文件为根目录的:web_demo.py 如果要替换7B大模型,可以打开这个文件找到Qwen-1_8B-Chat-Int4,替换为Qwen-7B-Chat-Int4

api运行文件为根目录的:api.py 如果要替换7B大模型,可以打开这个文件找到Qwen-1_8B-Chat-Int4,替换为Qwen-7B-Chat-Int

本地搭建api的为post请求,请求的接口以php为例:

并且api的为post请求,你请求的接口以php为例:

// 创建一个cURL资源

$ch = curl_init();

// 设置URL和其他选项

$url = 'http://127.0.0.1:8001/v1/chat/completions'; // 替换为你的目标URL

curl_setopt($ch, CURLOPT_URL, $url);

curl_setopt($ch, CURLOPT_POST, true);

curl_setopt($ch, CURLOPT_TIMEOUT, 6000);

curl_setopt($ch, CURLOPT_SSL_VERIFYPEER, false);

curl_setopt($ch, CURLOPT_SSL_VERIFYHOST, false);

curl_setopt($ch, CURLOPT_POSTFIELDS, json_encode([

'model' => 'gpt-3.5-turbo',

'messages' => [

['role' => 'user', 'content' => $keyword]

]

]));

curl_setopt($ch, CURLOPT_HTTPHEADER, array(

'Connection: keep-alive',

'Content-Type: application/json',

'Content-Length: ' . strlen(json_encode([

'model' => 'gpt-3.5-turbo',

'messages' => [

['role' => 'user', 'content' => $keyword]

]

]))

));

curl_setopt($ch, CURLOPT_RETURNTRANSFER, true);

// 执行请求并获取响应

$response = curl_exec($ch);

var_dump($response);欢迎大家开心使用吧!本模型本来就是开源不收费的,因为需要自己时间打包整合,所以象征性收30元,如果有其他问题也可以一起讨论学习!